无需训练的世界模型?西湖大学WorldForge开启空间智能新路径,让AI读懂3D世界

无需训练的世界模型?西湖大学WorldForge开启空间智能新路径,让AI读懂3D世界近来,由AI生成的视频片段以前所未有的视觉冲击力席卷了整个互联网,视频生成模型创造出了许多令人惊叹的、几乎与现实无异的动态画面。

近来,由AI生成的视频片段以前所未有的视觉冲击力席卷了整个互联网,视频生成模型创造出了许多令人惊叹的、几乎与现实无异的动态画面。

腾讯混元 3D 发布了全新 3.0 版本,带来了更丰富的细节和更真实的质感,我们的创意可以不用停留在文字、图片或视频,而是现实世界里,能够摸得着的物理实体。

作为AI驱动的3D建模平台,Tripo(https://www.tripo3d.ai)已在全球覆盖超300万专业开发者,AI 3D原生模型数量超过4000万,中小用户超4万,并推出了一站式AI 3D工作台Tripo Studio

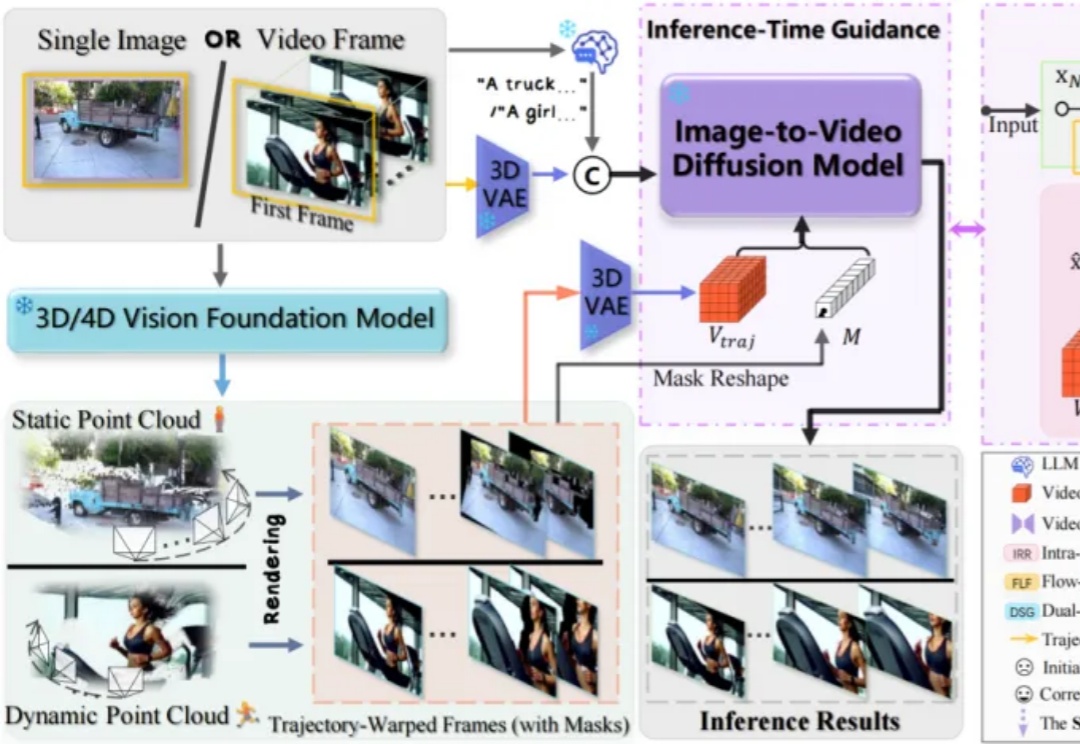

香港科技大学谭平教授团队与地平线(Horizon Robotics)团队最新发布了一项 3D 场景表征与大规模重建新方法 SAIL-Recon,通过锚点图建立构建场景全局隐式表征,突破现有 VGGT 基础模型对于大规模视觉定位与 3D 重建的处理能力瓶颈,实现万帧级的场景表征抽取与定位重建,将空间智能「3D 表征与建模」前沿推向一个新的高度。

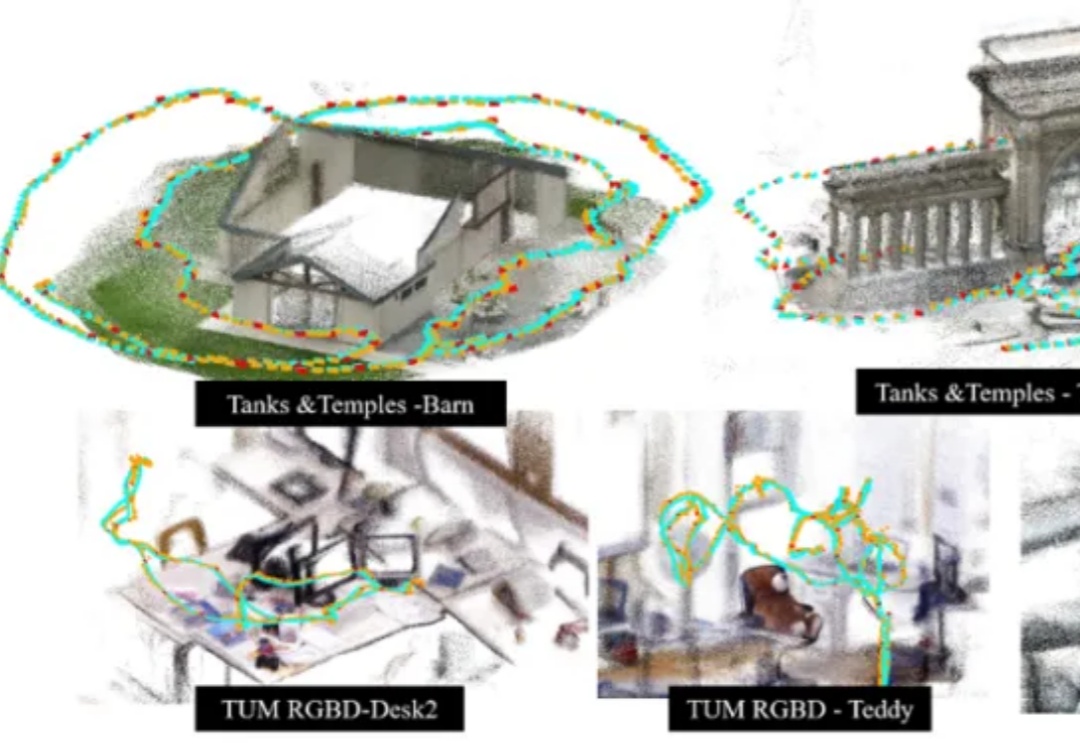

开放词汇识别与分类对于全面理解现实世界的 3D 场景至关重要。目前,所有现有方法在训练或推理过程中都依赖于 2D 或文本模态。这凸显出缺乏能够单独处理 3D 数据以进行端到端语义学习的模型,以及训练此类模型所需的数据。与此同时,3DGS 已成为各种视觉任务中 3D 场景表达的重要标准之一。

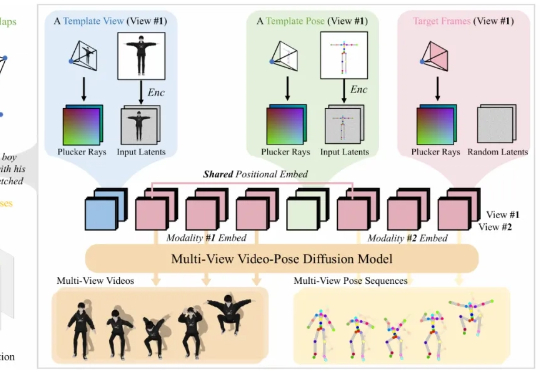

在游戏、影视制作、虚拟人和交互式内容创作等行业中,高质量的 3D 动画是实现真实感与表现力的基础。然而,传统计算机图形学中的动画制作通常依赖于骨骼绑定与关键帧编辑,这一流程虽然能够带来高质量与精细控制,但需要经验丰富的艺术家投入大量人力与时间,代价昂贵。

只需要一句话或一张图片,就能生成360度全景3D世界。

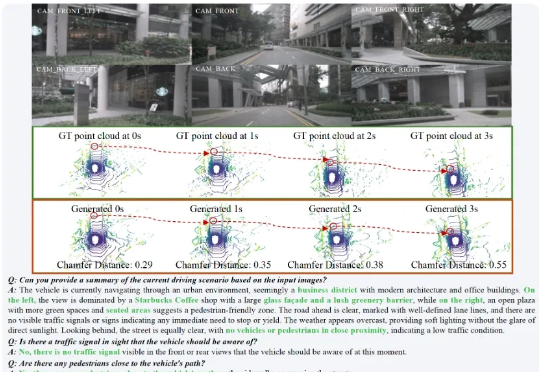

在复杂的城市场景中,HERMES 不仅能准确预测未来三秒的车辆与环境动态(如红圈中标注的货车),还能对当前场景进行深度理解和问答(如准确识别出 “星巴克” 并描述路况)。

现在这个时代,啥都讲究一句话生成。一句话P图、一句话写文案、生成画作、音乐、视频… 不过这些,在今天的想法面前,都显得有些弱了。

最近体验了一个 AI 工具的内测版本,确实跟之前见到的AI产品不太一样。 它做的事情是:一句话,生成一个完整可玩的3D游戏。